RAG versus ajuste fino para IA de conversação

See the power of intelligent conversations for your brand.

As conversas orientadas por IA deixaram de ser um “bom ter” futurista para se tornarem uma vantagem comercial essencial. Seja para responder às perguntas dos clientes, auxiliar as equipes de vendas ou dar suporte às operações internas, você pode ter uma vantagem comercial essencial. IA conversacional está reformulando a forma como as empresas se envolvem e escalam.

Mas a implementação de agentes de IA não se resume a escolher um modelo e entrar em operação. Em vez disso, ela começa com uma decisão crítica: qual é a abordagem certa para suas necessidades?

Você deve implementar a Geração Aumentada por Recuperação (RAG), ajustar os Modelos de Linguagem Grandes (LLMs), ou combinar as duas abordagens?

Ambos têm recursos poderosos. Ambos oferecem benefícios exclusivos. Mas cada um também traz alguns desafios dos quais você precisa estar ciente.

Escolher a opção certa – ou saber quando combiná-las – pode não apenas moldar a experiência do cliente, mas também ajudar a controlar os custos operacionais e a gerar resultados comerciais.

Neste blog, detalharemos o RAG e o Fine-Tuning em termos simples, exploraremos exemplos reais e ajudaremos você a decidir qual abordagem se adapta melhor às suas metas, quer você esteja buscando precisão factual, otimizando os custos de implementação, mantendo a consistência da voz da marca ou equilibrando os três. Também ajudaremos você a avaliar se a sua organização está realmente pronta para empreender os esforços de desenvolvimento com uso intensivo de recursos que o ajuste fino exige ou se o aproveitamento das soluções existentes pode oferecer melhores resultados. ROI.

Entendendo os blocos de construção: Explicação sobre o RAG e o ajuste fino

RAG em termos simples

O Retrieval-Augmented Generation (RAG) funciona como uma IA com acesso a uma biblioteca de referência. Simplificando, o RAG permite que os LLMs pesquisem antes de responder. Quando um cliente faz uma pergunta, o sistema:

1. O LLM pesquisa em uma base de conhecimento (documentação da empresa, manuais de produtos, perguntas frequentes, documentos de ajuda, wikis internos etc.)

2. Recupera as informações mais relevantes

3. Usa as informações recuperadas para gerar uma resposta precisa e contextual

Pense nele como um agente de agente de IA que verifica a documentação da sua empresa antes de responder a uma pergunta do cliente.

Exemplo do mundo real: O agente de IA do gerente de relacionamento bancário da Gupshup usa o RAG para acessar informações atualizadas sobre políticas, taxas de juros e detalhes da conta para fornecer respostas precisas sobre produtos e serviços bancários.

A IA fornece informações precisas porque a base de conhecimento é atualizada regularmente com tarifas atuais, alterações de políticas e ofertas promocionais, garantindo que os clientes sempre recebam as informações mais atualizadas sem a necessidade de retreinamento do modelo.

Ajuste fino em termos simples

Agora imagine que sua IA é como um assistente pessoal que trabalha com sua equipe há anos. Você a treinou em todas as suas conversas, tons, jargões e comportamentos anteriores.

Ajuste fino significa treinar novamente um LLM básico em exemplos específicos, como os registros de bate-papo do atendimento ao cliente da sua marca, documentos, tom de voz e linguagem de domínio. Ele aprende profundamente e responde como se já tivesse aprendido. sabe você está trabalhando. É mais como se você estivesse ensinando seu negócio a um LLM. Por meio de treinamento adicional em seus dados específicos, o modelo aprende:

1. Seus produtos e serviços

2. O estilo de comunicação de sua marca

3. Como lidar com cenários comuns de clientes

Após o ajuste fino, o modelo internalizou esse conhecimento e não precisa procurar informações para cada consulta.

Quando usar o quê: exemplos do mundo real

Quando usar o RAG: casos de uso e exemplos

1. Conteúdo dinâmico e informações em constante mudança

Ideal para: Setores em que o catálogo de produtos, as políticas, os preços, a disponibilidade de estoque ou os procedimentos mudam com frequência.

Quando sua empresa opera em um ambiente dinâmico com atualizações constantes de produtos, serviços ou políticas, o RAG oferece uma vantagem significativa. Como o sistema recupera informações em tempo real, você pode simplesmente atualizar sua base de conhecimento e o agente de IA conversacional terá acesso imediato às informações mais recentes, sem necessidade de retreinamento.

Exemplo:

- Um varejista de produtos eletrônicos atualiza seus termos de garantia a cada trimestre. Um cliente pergunta sobre a garantia de um modelo recém-lançado.

→ RAG do Gupshup Agente de IA de vendas de garantia busca a ficha do produto mais recente e dá uma resposta atualizada e legalmente precisa. - Agente de IA de Agente de IA de gerenciamento de pedidos da Gupshup usa o RAG para acessar as informações mais recentes sobre o status da entrega do seu parceiro de logística, permitindo que ele forneça atualizações precisas de rastreamento, mesmo quando os detalhes da remessa mudam ao longo do dia.

2. Respostas factuais e baseadas em políticas

Ideal para você: Quando a precisão e a exatidão não são negociáveis

Se a sua empresa precisa de precisão nas respostas, como sobre produtos, detalhes da conta, políticas, isenções de responsabilidade legais, conformidade ou dados financeiros, o RAG garante a precisão, fundamentando as respostas na realidade.

Exemplo:

- Um usuário de aplicativo de fintech pergunta, “Quais são as taxas de juros atuais de empréstimos imobiliários para profissionais assalariados?”

→ O RAG acionou o Agente de IA de assistência a empréstimos faz referência ao PDF mais recente do produto e responde com a taxa exata, a elegibilidade e os T&Cs.

3. Bases de conhecimento complexas

Ideal para: Quando a documentação é extensa e detalhada

As organizações com vasta documentação se beneficiam da capacidade do RAG de pesquisar e recuperar informações de extensas bases de conhecimento. Em termos mais simples, se você tiver milhares de FAQs ou documentos técnicos, o RAG ajuda a navegar e a fornecer respostas sem a necessidade de memorizar tudo.

Exemplo:

Agentes de IA do Gupshup Agentes de IA do setor de saúde da Gupshup utilizam o RAG para navegar por 10 a 15 mil perguntas frequentes e fornecer orientações precisas sobre saúde, mantendo as isenções de responsabilidade médicas adequadas e encaminhando você para atendimento profissional quando necessário.

Quando usar o ajuste fino: Casos de uso e exemplos

1. Conhecimento do domínio e compreensão da jornada do cliente

Ideal para você: Quando o conhecimento profundo do domínio e a experiência na jornada do cliente são essenciais

O ajuste fino ajuda o seu agente de IA a realmente entender as nuances de um setor e os diferentes estágios do funil da jornada do cliente. Em vez de simplesmente responder a consultas, um modelo ajustado pode reconhecer onde os clientes estão em sua jornada e fornecer orientação adequadamente adaptada.

A IA da Gupshup usa o ajuste fino para desenvolver recursos especializados, como recomendações de produtos contextualmente relevantes, compreensão de decisões de compra complexas e orientação eficaz dos clientes para a conclusão de transações. Por exemplo, no banco de varejo, a IA reconhece quando um cliente está pesquisando opções de hipoteca e quando está pronto para enviar uma solicitação, ajustando sua abordagem de acordo para fornecer o nível certo de informações e assistência.

Exemplo:

Um cliente de banco de varejo interage com um agente de IA ajustado durante sua jornada de compra de casa. Em vez de simplesmente responder: “Nossa taxa de hipoteca é de 5,75%,”

diz o modelo ajustado:

“Vejo que você está explorando opções de hipoteca. Nossa taxa atual é de 5,75%, mas como você está comprando sua casa pela primeira vez, talvez se qualifique para nosso programa especial com requisitos de entrada mais baixos. Você gostaria que eu o orientasse sobre suas opções com base no seu orçamento?”

2. Conhecimento de domínio especializado

Ideal para você: Setores com terminologia e conceitos exclusivos

Em campos especializados com linguagem específica do domínio, o ajuste fino ajuda a IA a entender a terminologia e os conceitos do setor sem referência constante à documentação.

Exemplo: Os GPTs treinados no setor para os setores bancário, de saúde e automotivo são aperfeiçoados em conhecimentos específicos do domínio, o que lhes permite entender termos e processos especializados.

Por exemplo, ajuste fino para o setor bancário começa com a coleta e o processamento de dados de treinamento. A Gupshup se baseia em profundo conhecimento do domínio, fontes de dados proprietárias, exemplos criados e sintetizados por humanos e conjuntos de dados públicos relevantes para criar um conjunto de dados de alta qualidade especificamente adaptado para aplicativos bancários. A síntese de dados também não é simples, pois leva meses para determinar que tipo de dados será útil para o treinamento.

3. Padrões de consulta previsíveis

Ideal para você: Quando a maioria das perguntas se enquadra nas categorias esperadas

Quando as interações com os clientes seguem padrões previsíveis, o ajuste fino pode preparar a IA para lidar com esses cenários comuns de forma eficiente.

Exemplo: Um caso de uso do EMI Collections aproveita um modelo ajustado, como o ACE LLM para lidar com consultas comuns relacionadas a pagamentos, termos e condições, explicando aos clientes as implicações de pagamentos atrasados, compreendendo as dificuldades de pagamento e oferecendo orientação adequada.

4. Requisitos complexos para a tomada de decisões

Ideal para você: Cenários que exigem um julgamento diferenciado com base no conhecimento implícito

Nos casos em que as decisões dependem de fatores sutis não explicitamente documentados, o ajuste fino pode ajudar o modelo a desenvolver o julgamento necessário para essas situações.

Exemplo: A consultoria financeira requer um entendimento profundo, e um LLM bem ajustado que tenha sido treinado em milhares de interações anteriores com clientes pode entender melhor os fatores implícitos que influenciam as recomendações financeiras adequadas, mantendo a conformidade com as normas.

O poder das técnicas híbridas

Para muitas empresas, a abordagem mais eficaz combina o RAG e o ajuste fino para aproveitar os pontos fortes de cada método.

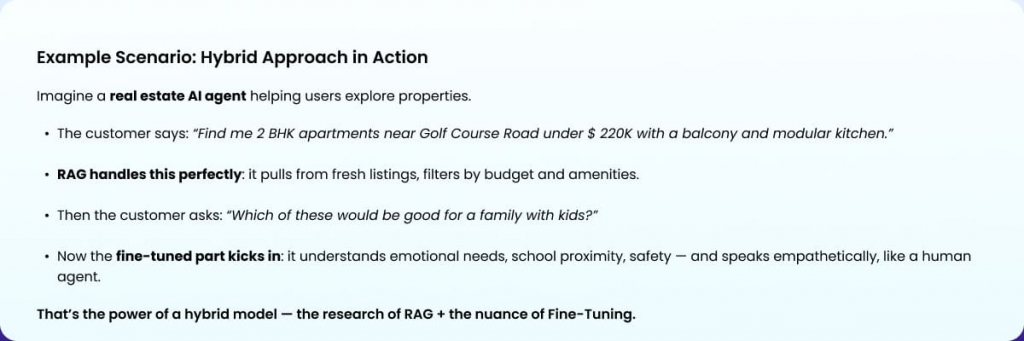

1. Jornadas de clientes complexas

Ideal para você: Combinar a precisão dos fatos com a compreensão das nuances

As jornadas do cliente que envolvem tanto a recuperação de informações específicas quanto a compreensão diferenciada da intenção do cliente se beneficiam de uma abordagem híbrida.

Exemplo: O Property Discovery AI Agent da Gupshup combina o RAG para recuperar detalhes específicos de propriedades com uma lógica ajustada para qualificar clientes em potencial e entender suas preferências e restrições de moradia.

2. Sistemas de suporte multifuncional

Ideal para: Quando o mesmo agente lida com diversas interações

Os sistemas de IA que precisam executar várias funções – desde o fornecimento de informações até a solução de problemas complexos – se beneficiam de ambas as abordagens.

Exemplo: O agente de IA para viagens e hospitalidade da Gupshup usa ambas as abordagens para lidar com reservas (usando o RAG para obter disponibilidade e preços precisos) e, ao mesmo tempo, fornece recomendações personalizadas com base em uma compreensão refinada das preferências do viajante.

Use Case Matrix for RAG, Fine-Tuning, and Combination Approaches

When deciding between RAG, Fine-Tuning, or a Hybrid approach for your conversational AI, it’s important to consider the specific needs of your business. Below, we’ve mapped out various use cases to help you understand which method works best for different scenarios and industries.

Use Case

Best Fit Why Example

Constantly Changing Content (policies, SKUs, features) RAG RAG keeps information updated without needing retraining. E-commerce - pulling live data to give accurate details on new product arrivals, offers, item availability or discounts.

High-Touch Industries (finance, luxury, healthcare) Fine-Tuning Ensures brand-specific tone, empathy, and domain expertise. Healthcare AI Agent providing empathetic responses with medical knowledge about symptoms and treatments.

Multilingual Support Across Markets RAG RAG can pull information from localized documents or databases on the fly. Travel AI Agent fetching up-to-date hotel information and policies in various languages.The system also pulls real-time weather data to advise travelers on what to pack.

Need Both Freshness & Tone (e.g., FAQs and conversational support) Hybrid Combines RAG for up-to-date info and Fine-Tuning for brand-specific tone and personalized responses. Retail AI Agent providing product recommendations (RAG) and customer service with a luxury brand tone (Fine-Tuning).

Handling Highly Specialized Domain Knowledge Fine-Tuning Fine-tuning enables deeper understanding of industry-specific terminology. Legal AI Agent fine-tuned on law firm documents and case precedents to answer clients accurately with guardrails that maintain confidentiality, include appropriate disclaimers, and flag complex issues for attorney review..

Real-Time Information (stock levels, order status, etc.) RAG RAG provides real-time data retrieval from dynamic sources. Order Management AI Agent pulling live data on stock levels or delivery status for real-time updates.

Handling Multiple Functions (bookings, recommendations, customer service) Hybrid Combines RAG for accurate product details and Fine-Tuning for conversational flow and personalized service. Travel & Hospitality AI Agent booking flights, recommending destinations, and assisting with customer service inquiries.

Long-Term Knowledge Retention and Contextual Understanding Fine-Tuning Fine-tuning builds a model with memory and contextual understanding over time. Insurance Claims AI Agent studies all past claims and settlements to evaluate evidence for new claims to determine admissibility, and provides tailored support based on customers' claims history and interaction patterns..

Handling Complex, Less Frequent Queries RAG RAG ensures accuracy by fetching information for queries that don’t have pre-defined answers. Banking AI Agent fetching live, updated terms and conditions for loan eligibility or interest rates when asked by a customer.

Need for Speed (low latency in responses) Fine-Tuning Fine-tuning allows for fast responses as it doesn't rely on external queries. E-commerce AI Agent trained on product catalogs instantly answers customer questions about item details, availability, and compatibility, making the shopping experience faster and smoother.

Prós e contras de RAG vs. ajuste fino

Cada estratégia de IA tem seus próprios pontos fortes e limitações. Enquanto o RAG oferece agilidade e precisão em tempo real, o Fine-Tuning oferece profundidade, consistência e velocidade…

Compreender os benefícios e os desafios de cada abordagem pode ajudar você a tomar uma decisão informada com base no custo, na velocidade, no esforço de manutenção e nos resultados comerciais.

RAG (Retrieval-Augmented Generation)

| Pros | Cons |

|---|---|

| Easily updated with new information without retraining (updates in minutes to hours) | Requires a well-organized and up-to-date knowledge base |

| Direct access to the latest company documentation | May struggle with questions not covered in the documentation |

| Transparent citations to source material, improving trust and compliance | Higher per-query computing costs due to real-time retrieval operations |

| Reduced hallucinations when reliable information exists | Slower runtime compared to pre-trained models |

| Faster deployment with minimal training requirements (initial setup: 1–4 weeks) | Ongoing costs include vector database infrastructure, content management, and knowledge base maintenance |

LLM Fine-Tuning

| Pros | Cons |

|---|---|

| Strong understanding of domain-specific concepts and internalized knowledge | Requires full retraining when business or documentation changes (updates take weeks to months) |

| Consistent tone, communication style, and brand voice | Higher upfront investment in ML engineering, compute, and infrastructure |

| Handles implicit queries and edge cases with greater reasoning ability | Risk of hallucination in unfamiliar scenarios or when faced with new data |

| Faster runtime as there's no retrieval step involved | Needs significant volumes of clean, relevant, curated training data |

| Suitable for stable environments with less frequent updates (initial setup: 8-25 weeks) | Long-term maintenance includes retraining costs, hosting, and expert oversight, intensive computational requirements across multiple GPUs, and substantial memory storage due to the large size of the LLM. |

Benefits Summary:

| Benefit Area | RAG (Retrieval-Augmented Generation) | Fine-Tuning |

|---|---|---|

| Accuracy | Pulls real-time info from a knowledge base, ensuring factual and traceable answers | Learns domain-specific patterns and language for consistent, intuitive responses |

| Hallucination Control | Reduces risk of incorrect answers by sticking to verified content; can say "I don’t know" | Can be trained to recognize uncertainty and respond cautiously in unfamiliar situations |

| Deployment Speed | Fast to launch with existing content; updates are quick—no retraining needed | Slower setup due to training needs, but offers long-term consistency once established |

| Customer Experience | Best for factual, technical, or policy-related queries, even edge cases | Delivers smoother, brand-aligned conversations with better multi-turn context handling |

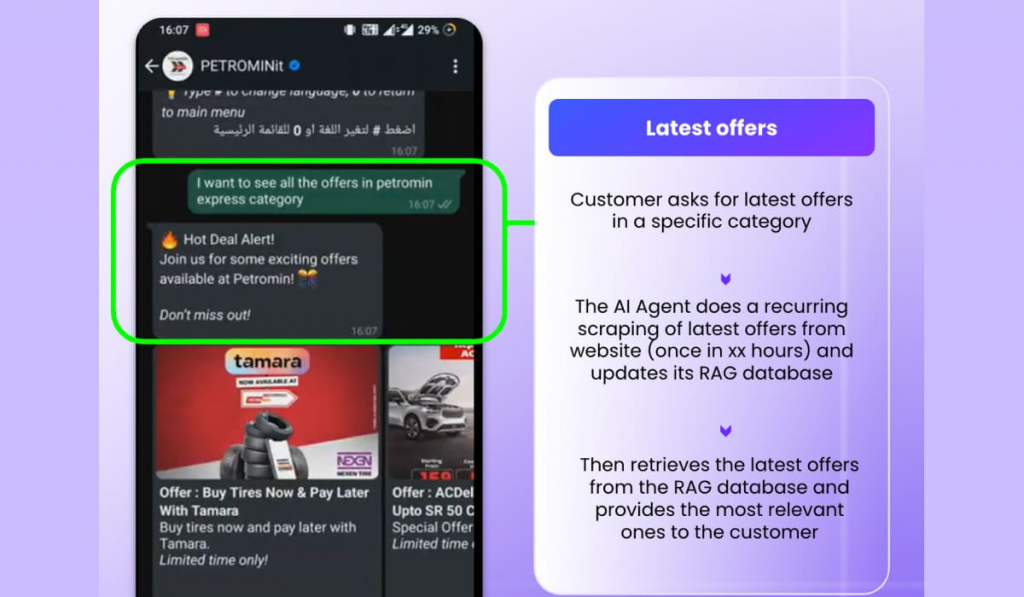

Caso de uso no mundo real: como a Petromin utiliza o RAG para entregar ofertas oportunas

Agente de IA da Petromin Agente de IA Autocare da Petromin da Petromin demonstra o que há de melhor em Retrieval-Augmented Generation (RAG). Desenvolvido em parceria com a Gupshup, ele fornece automaticamente apenas promoções atuais e relevantes aos clientes com base em seus interesses específicos na categoria.

Eliminando a necessidade de atualizações manuais do banco de dados de ofertas, os agentes de IA extraem as ofertas do site e as atualizam no banco de dados do RAG. Isso garante que os clientes nunca recebam ofertas expiradas, mas obtenham informações oportunas sobre promoções ao vivo que atendam às suas necessidades.

Isso reduz a carga administrativa e melhora significativamente a precisão e a relevância do marketing.

Empresas como a Petromin personalizam o conteúdo e as ofertas em escala.

Estrutura de decisão: Escolhendo a abordagem correta

Escolher entre o RAG e o ajuste fino não é uma questão de certo ou errado, mas sim do que funciona melhor para você. melhor para o estágio de seus negócios, a disponibilidade de dados e as expectativas dos clientes.

- RAG é ideal para a maioria das empresas, especialmente se sua documentação for sólida e atualizada com frequência.

- Ajuste fino funciona melhor para necessidades de nível empresarial em que o tom, a conformidade ou a especialização são importantes.

- Híbrido oferece o padrão ouro – se você estiver pronto para a complexidade e quiser realmente dimensionar conversas inteligentes.

Assim, tanto a Geração Aumentada por Recuperação (RAG) e LLM Fine-Tuning trazem pontos fortes exclusivos para a IA conversacional. O RAG se destaca em ambientes com conteúdo que muda rapidamente, oferecendo acesso em tempo real a informações precisas. O ajuste fino, por sua vez, é excelente para fornecer um tom consistente, uma compreensão mais profunda do domínio e um fluxo de conversa mais natural.

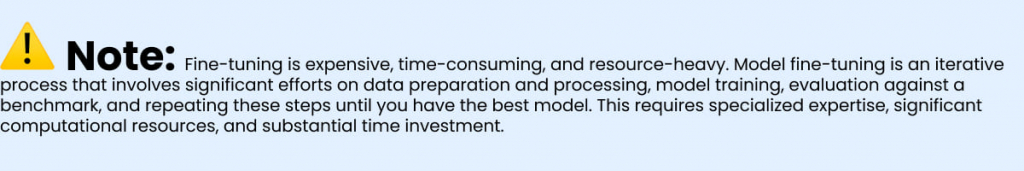

As empresas devem pensar bem antes de fazer o ajuste fino de forma independente. O esforço necessário é considerável, exigindo conhecimento especializado em ML, recursos de computação significativos, preparação extensiva de dados, limpeza e validação. Normalmente, o processo leva de 3 a 8 semanas no início, com necessidades de manutenção contínua. Considere se o investimento vale a pena com base em sua estratégia de longo prazo, nos recursos disponíveis e em quanto tempo suas informações permanecerão relevantes antes de exigir atualizações.

No entanto, ao combinar essas abordagens, as empresas podem criar agentes de IA poderosos que não sejam apenas confiáveis em termos de fatos, mas que também sejam conscientes do contexto e alinhados à marca. Isso estratégia híbrida oferece os melhores resultados ao combinar os pontos fortes de ambos os métodos. Comece com o RAG para uma implantação rápida e precisão factual e, em seguida, adicione estrategicamente elementos de ajuste fino para melhorar a qualidade da conversação em padrões de interação estáveis e de alto valor. Essa abordagem em fases permite que você obtenha valor imediato e, ao mesmo tempo, desenvolva experiências mais sofisticadas ao longo do tempo.

Na Gupshup, vimos em primeira mão como essa abordagem em camadas, abordagem multimodal em camadas-A abordagem de inteligência artificial da sua empresa, que combina texto, voz e interfaces visuais, transforma as experiências dos clientes em setores como bancos, varejo, saúde e outros. Nossos agentes de IA foram criados para atender às suas necessidades – rápidos, inteligentes e personalizados para a sua marca – ao mesmo tempo em que aproveitam um pilha flexível de LLM. À medida que os modelos se tornam mais leves e especializados, o uso de LLMs ajustados e específicos para cada caso de uso pode reduzir significativamente os custos e o esforço de desenvolvimento

Você está pronto para vê-lo em ação?

Agende uma consulta para explorar como os agentes de IA da Gupshup podem elevar sua estratégia de interação com o cliente.

Read: Como os agentes de IA conversacional liberam o tempo dos corretores de imóveis para vender mais casas

+91-9355000192

+91-9355000192 Entrar

Entrar